AI Token 介紹:理解 LLM、AI 搜尋的重要基本知識

讀懂 token,我們就掌握了生成式 AI 的出入、輸出的核心概念。

你或許沒聽過「Token」,Token 它正悄悄決定我們跟 AI 對話能說多少話、花多少錢,甚至左右一個專案一天能否跑完所有工作流程。

想像你把長篇小說塞進一台超級翻譯機:書頁會瞬間被裁成一顆顆「字粒」——這些字粒就是 token。

越多 token,機器就要翻得越久、收費越高;反之,精準切割、巧妙重組,既能壓低成本,也能讓 AI 模型更容易理解你的內容。

接下來,我們將帶你走進這顆看似微小、卻牽動算力、成本與創意邊界的「字粒宇宙」——讀懂 AI token,我們就掌握了生成式 AI 輸入、輸出的核心概念。

Token 是什麼?

Token 就是模型看文字時用的「最小拼圖片」。

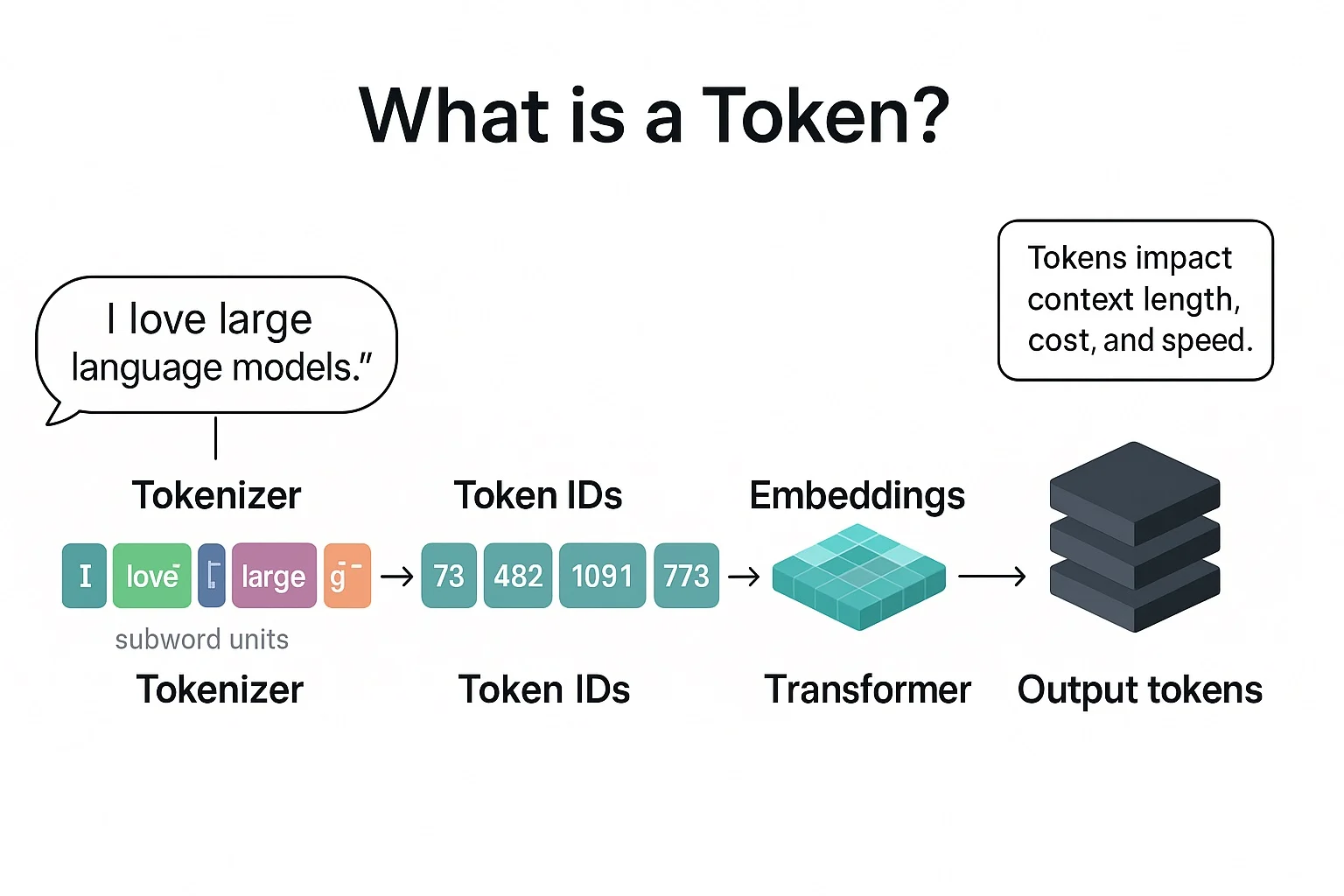

Token 不是一定等於一個字或一個詞,而是把文字切成常見的字串片段(subword)、單一字元,或特定符號,再把它們變成數字給模型吃。

在 AI 裡,「Token(符記)」就是模型處理與產生文字時最小的計算單位——像樂高積木一樣,小到可以自由拼裝,大到能搭出整段文章。模型只看得見這些「積木」,再把它們轉成數字向量去學習與推理。

白話文舉例

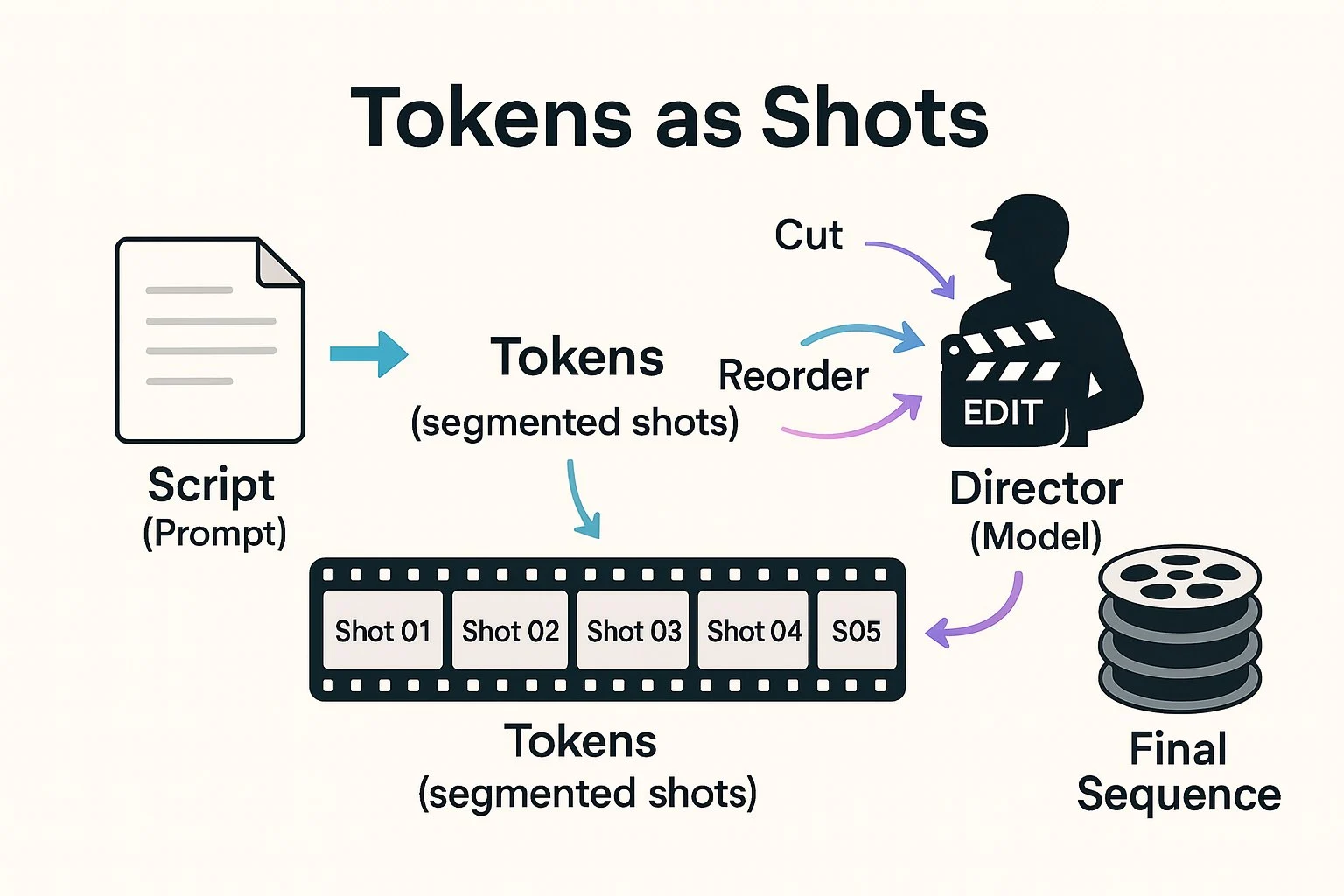

電影分鏡:把整部片切成鏡頭(Token),導演(模型)讀腳本時就能快速瀏覽、剪輯、重組。

Token 大小長什麼樣?

英文約 1 Token ≈ 4 個字元 ≈ ¾ 個單字。短詞如 “chat” 可能是一顆 Token;長詞 “unbreakable” 多半被拆成 “un-” 和 “breakable”。

中文在這類模型裡,通常是用 BPE 或 SentencePiece 這種子詞演算法,直接在字串上找「常出現的片段」來切;結果有時會剛好對齊單字、有時是一整個詞,或幾個字的組合,並不是硬性按照字根或拼音規則。

為什麼要把文字切成 Token?

- 電腦只認得數字:把字劈開成 Token,再映射成 ID,才能丟進矩陣運算。

- 控制字典大小:若每個單字都給一個編號,字典會爆炸;所以主流做法使用「子詞(sub-word)」演算法,例如 BPE,先把常見片段合併,不常見字再拆細。實務上幾萬到十幾萬個 subword token 的詞表,就足以涵蓋多語言內容。

- 解決生僻字與錯字:拆得夠細,模型就算沒見過整個單字,也能靠子詞片段理解大意。

Token 也等於「錢」

雲端 API(OpenAI、Azure、Anthropic…)普遍按「輸入/輸出Token」計價:你送 100 Token 的問題,模型回 300 Token,總消耗 400 Token。

價格依模型而異,業界也把「成本/千 Token」當成 KPI 來優化。

Token 的費用

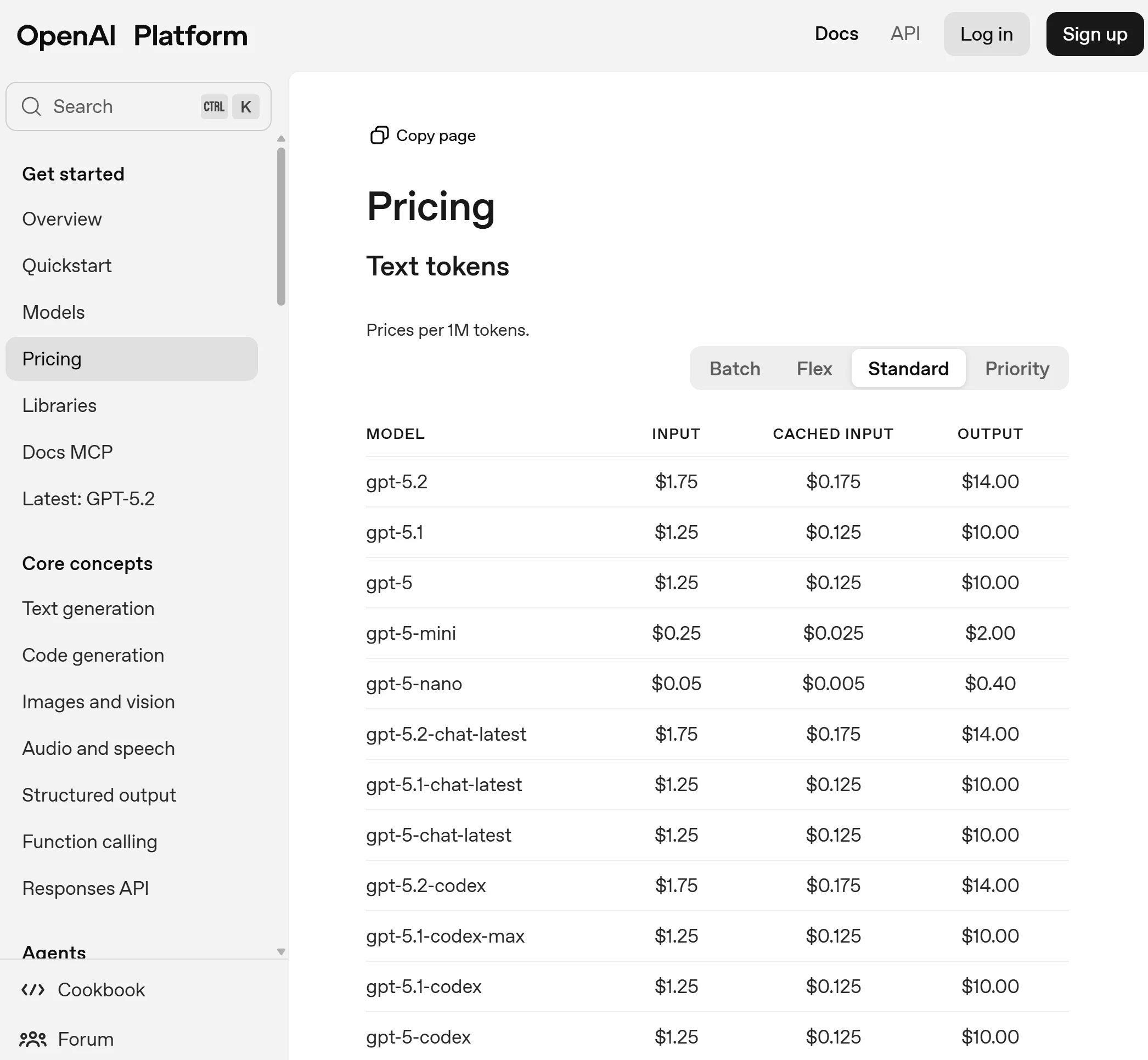

OpenAI(API:Text tokens,Standard / Batch / Flex / Priority)

OpenAI 的 Text tokens 價格表把 Batch、Flex、Standard、Priority 分開列;同一模型在 Batch/Flex 通常比 Standard 便宜,Priority 則更貴。

常見代表(Standard,$/1M tokens):

- gpt-5-mini:Input 0.25|Cached input 0.025|Output 2.00

- gpt-5.1(或 gpt-5):Input 1.25|Cached input 0.125|Output 10.00

- gpt-4o-mini:Input 0.15|Cached input 0.075|Output 0.60

資料時間:2026.1.21

關於更多不同模型的 Token 費用,可以參考:

Helicone – LLM API Pricing Calculator(helicone.ai/llm-cost)

- 覆蓋:標榜 300+ models、10+ providers

- 亮點:提供 API 端點可抓「每 1M tokens 的 input/output 成本」,也可用參數篩選 provider/model,甚至輸出 CSV(很適合你做自動更新到試算表/儀表板)。

- 網址:https://www.helicone.ai/llm-cost

透過《SEO 排名攻略學》獲得穩定的 SEO 流量與實戰經驗。

再搭配《AI SEO 流量變革》看懂 AI 搜尋趨勢,搶佔 AI 搜尋紅利。

Token 長度對比

先感覺一下「尺度感」:1 Token ≈ 多少文字?

- 英文:1 Token 約等於 0.75 個英文單字、4 個字元,也就是每 1,000 Token 可容納大約 750 個單字。

- 中文:因為中文在 GPT 這類模型裡通常會被拆得比較碎,粗略估算可以反過來看——1 個中文字大約需要 1.5–2 個 token,所以 1,000 token 大概只能放 500–650 個漢字。

對 GPT 這類模型來說,一個中文字通常會佔 1.5–2 個 token,也就是 1 token 大約只有 0.5–0.65 個漢字。實務上 1,000 token 大概可以放 500–650 個中文字,精確值要看內容與模型。

簡易公式

- 估算:中文字數 ≈ Token ÷ 1.5~2

- 例如:1,000 token ≈ 500–650 個漢字

透過《SEO 排名攻略學》獲得穩定的 SEO 流量與實戰經驗。

再搭配《AI SEO 流量變革》看懂 AI 搜尋趨勢,搶佔 AI 搜尋紅利。

把 256K Token 轉成「紙本厚度」

ChatGPT GPT-5 的 256K 上下文視窗,換算成每種語言。

英文

- 約 192,000 單字(256,000 Token × 0.75)。

- 以市面小說常見的 300 字/頁估算,相當於 640 頁左右;若採 280 字/頁的平均電子書排版,則約 685 頁。

中文

- 依「1 個中文字約需要 1.5–2 個 token」粗估:256K token 大約可以容納 13–17 萬個中文字(實際值會依內容變動)。

- 以常見 500 字/頁的排版計算,大約 260–340 頁的篇幅。

延伸閱讀:《ChatGPT 怎麼用?ChatGPT 教學:帳號註冊、22 種技巧》

256K Token 夠裝下一本什麼樣的書?

- 《Order of the Phoenix》 約 257K 單字,以 1 token ≈ 0.75 單字估算,大概是 33–34 萬 token,比 256K 視窗稍微大一點,實作上還是要分段餵給 GPT-5。

- 《War and Peace》 約 587K 單字,約 78 萬 token,則更需要分批處理。

為什麼 SEO 人員需要理解 Token?

在 2026 年以後,搜尋已不只是演算法排名的遊戲,而是同時面向「傳統 SERP + 生成式回答(GEO,Generative Engine Optimization)」的雙軌競爭。

無論是 Google Gemini、ChatGPT 還是各家垂直 AI 搜尋,內容在進入模型前都會被切成 token;理解這層切片規則,直接決定你的內容能否被完整索引、摘要、引用,甚至影響製作成本。

操作方向

- 關鍵句前置:把核心關鍵字與主張放在開頭 300–400 token,以防被長視窗模型截斷或被 snippet 裁掉。

- 主題叢集寫法:一頁解一題改為「一群相關問題 + 結構化標題」,增加在 Answer Box/AI 摘要中被整段引用的機率。

- 多語標準化分詞:使用支援 BPE 或 SentencePiece 的 CMS/插件確保 tokenizer 不會把外語品牌詞亂拆。

小結

在生成式搜尋時代,SEO 不只追關鍵字,而是要「管理 token」——讓重要語意落在模型能看見、能負擔的範圍內,才能同時贏得 SERP 排名與 AI 答案盒曝光。

透過《SEO 排名攻略學》獲得穩定的 SEO 流量與實戰經驗。

再搭配《AI SEO 流量變革》看懂 AI 搜尋趨勢,搶佔 AI 搜尋紅利。

AI Token 常見問題

AI 中的 token 是什麼?

在大型語言模型裡,token 就是模型讀取與產生文字時的最小單位,可是一個字母、字根或完整單字;模型把文字先切成一串 token,再進行運算及產生回應。

為什麼 AI 的 token 要花錢?

- 計算成本:每個輸入或輸出 token 都要經過數百億參數的矩陣運算,背後是昂貴的 GPU / TPU 叢集與電力。

- 基礎設施維護:服務商需投入資料中心、網路頻寬、模型升級與安全機制,費用透過按 token 計價回收。

- 定價方式:以 2025 年常用的 GPT-4o 為例,標準 API 定價大約是輸入 2.50 美元/100 萬 token、輸出 10 美元/100 萬 token。

簡單來說,token 收費本質上是為了補貼雲端算力與研發成本;用得多、佔用計算資源就越多,因而需要付費。

AI 的「Token」是什麼?

在大型語言模型裡,token 是模型切分文字的最小單位;它可能是一個字母、一部分單字,或(在中文裡)單個漢字。

模型先把輸入分成一串 token,再進行運算並依序產生新的 token 作為輸出。

ChatGPT 的 Token 怎麼計算?

OpenAI 計價與長度限制都用「輸入 token 數 + 輸出 token 數」來統計。

當你呼叫 Chat Completions API 時,回傳的 usage 欄位會列出 prompt_tokens(輸入)、completion_tokens(模型回覆)與 total_tokens 總和,這組數字同時拿來計費與檢查是否超過模型上限。

1 個 Token 大概多少字?

英文經驗值:1 token ≈ 4 字元,或約 ¾ 個單字。

中文常見情況:可以先抓「1 個漢字 ≈ 1.5 個 token」來估算;實際上有些字會被拆成更多 token,或跟前後字合併成一個更長的片段。

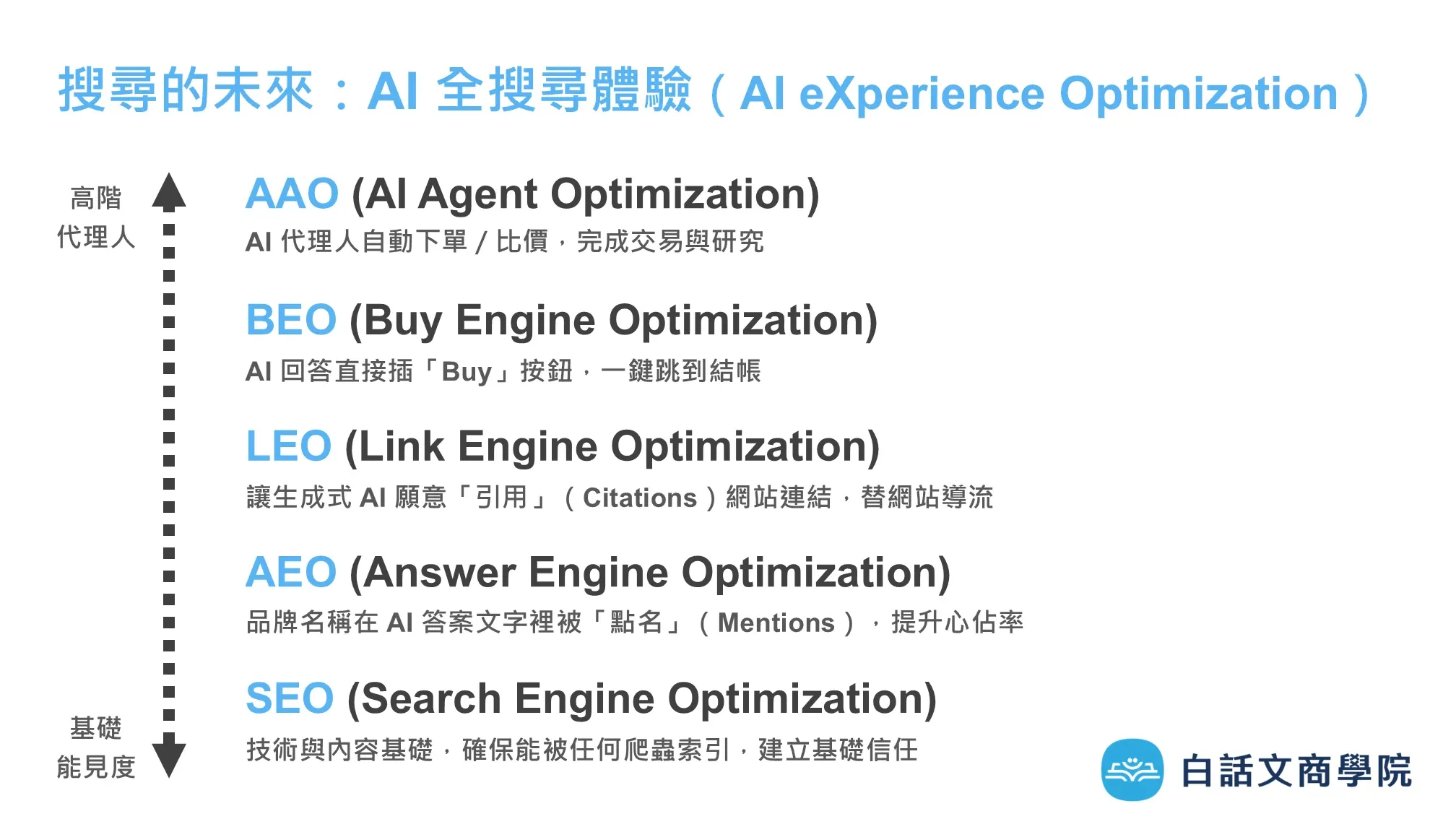

SEO 的新未來:AXO(AI eXperience Optimization)

隨著 AI 搜尋的發展,我們希望出現在各個 AI 搜尋引擎、各個垂直的搜尋引擎。

在 AXO(AI eXperience Optimization)中,我根據不同的層次,分類了 AAO、BEO、LEO、AEO、SEO,定義了不同的工作任務。

SEO 找得到 → AEO 說得到 → LEO 連得到 → BEO 買得到 → AAO AI 替你做到。

延伸閱讀:《AXO(AI 全搜尋體驗)介紹:一次理解搜尋的未來與布局》

透過《SEO 排名攻略學》獲得穩定的 SEO 流量與實戰經驗。

再搭配《AI SEO 流量變革》看懂 AI 搜尋趨勢,搶佔 AI 搜尋紅利。