RAG 是什麼?白話文理解「檢索增強生成」對 SEO 與 AI 影響

對行銷與 SEO 人來說,理解 AI 搜尋背後的 RAG(Retrieval-Augmented Generation)框架,等於拿到兩把槓桿:一把讓你的內容在檢索階段被判定為權威來源,另一把讓 AI 在生成摘要時主動附上品牌與連結。

現在的 AI 搜尋結果頁已經走向「先檢索、再生成」的雙引擎模式——Google AI Overviews、Bing、Perplexity、ChatGPT 都靠這套流程把答案塞進最顯眼的位置。

對行銷與 SEO 人來說,理解背後的 RAG(Retrieval-Augmented Generation)框架,等於拿到兩把槓桿:一把讓你的內容在檢索階段被判定為權威來源,另一把讓 AI 在生成摘要時主動附上品牌與連結。

只要同時優化「被找到」和「被引用」,就能在新一代 AI SERP 中提前卡位、引流並提升點擊率。

本文幫助無基礎的朋友也能了解 RAG 是什麼,以及 RAG 的運作流程。

RAG 是什麼?

RAG 是 Retrieval-Augmented Generation,檢索增強生成。

這個中文名稱也是直接對應到 RAG 三個字:Retrieval(檢索)、Augmented(增強、增補)、Generation(生成)。

RAG 是一種 AI 架構,透過「先檢索、後生成」的流程,讓大型語言模型(LLM)在回應前,即時向外部知識庫抓取最相關的文件片段,並把這些內容連同使用者問題一起餵給模型,於是模型得以在不重新訓練的情況下產生更即時、可追溯且事實正確的答案。

RAG 是一種將「外部知識檢索」與「大型語言模型(LLM)生成」結合的架構,是一種把「搜尋」和「生成式 AI」結合起來的技術流程。

RAG 之所以「必要」,在於它用外部可更新、可控、可引用的知識,這可以補足 LLM 天生的三大弱點──有限上下文、僵硬參數記憶與幻覺。

對希望把 AI 帶入真實業務、又要求準確、合規與成本可控的組織而言,RAG 幾乎已成必備基礎設施。

而目前的語言模型為了降低幻覺,就會利用 RAG 來降低錯誤。

為什麼 SEO 人員要理解 RAG?

2025 年,Google 的 AI Overviews 與每月處理超過 7.8 億次查詢的 Perplexity AI 等答案引擎,皆採用 Retrieval-Augmented Generation(RAG)技術。

出版商統計顯示,這些功能已導致 Google 自然流量普遍下降 1–25%,凸顯「能否被 RAG 檢索」決定曝光,因此我們需要理解 RAG。

RAG 透過向量語義比對擷取結構清晰、直接回答問題的段落,再生成摘要並附來源;若品牌內容未被召回,AI 可能引用競品或過時資料,衝擊聲譽與點擊。因此,SEO 人員必須理解 RAG 的檢索邏輯、內容切塊與結構化標記策略,並持續監控 AI 層的引用,才能在新搜尋生態找到立足點。

推薦閱讀:《How generative information retrieval is reshaping search》。

什麼是 Retrieval(檢索)?

為了更深度理解 RAG,我們需要先更了解「Retrieval」(檢索)的概念。

在資訊檢索(Information Retrieval, IR)的語境裡,retrieval 指的是「在使用者提出查詢(query)之後,從已經建立好的索引(index)中找出最相關的文件或片段」的過程。

包括:

- 解析使用者查詢並產生檢索表示(關鍵字、向量或其他特徵)。

- 到索引中快速比對並擷取一批候選文件。

- 依相關性對候選文件排序,必要時再進行 rerank。

傳統檢索方法多採用倒排索引 + BM25 / TF-IDF。

近年則大量使用向量檢索(embedding search)、雙階段檢索 (first-stage recall → reranker) 或在 RAG(Retrieval-Augmented Generation)管線中餵給大型語言模型。

白話解釋:Retrieval=「先把可能有用的東西先翻出來」的動作──就像你先把所有可能是鑰匙的東西倒在桌上,再細看哪一把能開門。

延伸閱讀:《Retrieval(檢索)介紹:索引之後、排名之前的關鍵搜尋環節》

什麼是 Augmented(增強)?

為了讓產生的答案更準確、資訊更豐富,「Augmented」意思是在產生文字之前,先把檢索到的知識(不管是原始段落、結構化資料,或經過前處理的摘要),轉換成適合給語言模型吸收的「增補上下文」 的過程。

包括:

- 篩選與過濾:從檢索結果中挑掉雜訊,只保留最相關、最可信的內容。

- 重組與壓縮:把多篇文件的重複段落合併、摘要,避免超長上下文超過 token 限制。

- 格式化與標註:加入標題、來源、分隔符,或用 JSON / Markdown 讓模型更容易定位重點。

- 補充與驗證:必要時再向知識庫查缺補漏,或透過規則、工具檢查事實一致性。

常見做法:

- Chunking + Metadata:把文件切片並保留章節標題、時間、作者等欄位;

- Prompt templating:把檢索片段塞進事先設計好的提示(prompt),例如 “你是資深律師,請根據以下條文回答使用者問題:…”;

- Chain-of-Thought / Toolformer 風格:先用外部工具計算、翻譯或查字典,再把結果回填給 LLM。

白話解釋:Augmented=「先把找到的資料整理、加料,變成模型看得懂的便當盒」──就像你先把食材洗淨、切好、依序排進便當,再交給大廚料理。

什麼是 Generation(生成)?

「Generation」指的是大型語言模型(LLM)根據輸入上下文,逐 token 預測並產出最可能文字序列 的步驟,也就是 RAG 管線的最後一棒──把檢索+增強後的知識轉換成對話、摘要或文件。

包括:

- 編碼上下文:把使用者問題+增強後文本一起轉成隱向量。

- 條件語言模型解碼:模型根據目前上下文機率分布,逐步取樣 / beam search 產生下一個 token。

- 後處理:可能加入 citation、格式修正、敏感詞過濾,確保輸出易讀且合規。

常見任務:

- 問答(QA)、聊天助理;

- 長文摘要、筆記生成;

- 代碼自動補全、翻譯、改寫;

- 多輪推理(Chain-of-Thought)、資料驅動報告。

白話解釋:Generation=「把備料好的食材烹調出道菜並擺盤」──就像是大廚根據食材特性決定火候、調味,最後端上一盤完整料理。

小結:三個名詞如何串成 RAG?

- Retrieval:快速把「可能相關的知識」找出來。

- Augmented:把找到的知識加工整理,變成模型能直接利用的上下文。

- Generation:由語言模型根據整理後的上下文,生成最終答案或內容。

整體就像 先翻找→備料→烹飪 的流程:找資料(Retrieval)→ 整理加料(Augmented)→ 生成成品(Generation)。

白話理解 RAG

類比成聊天版的「開書回答」

- 純 LLM 像一個記憶力超強、但只能靠自己腦袋的同學。

- RAG 就是讓這位同學考試時先翻課本/Google,把關鍵段落放到桌上,再根據這些段落組合成白話答案。

三個步驟,產生有理有據的資訊

- R – Retrieval 檢索:先把你的提問向量化/關鍵詞化,到資料庫、網頁或上傳的 PDF 裡撈出 k 段最相關的文字片段。

- A – Augmentation 增補:把「原始問題 + 這些片段(含標題或 metadata)」組合成新的 prompt,等於把外部知識「嵌」進去。

- G – Generation 生成:大型語言模型讀取經過增補的 prompt,基於注入的知識完成回答、推理或摘要;需要時再附上來源引用。

為什麼要這麼做?

- 不亂編:回答有根據,幻覺機率大幅降低。

- 資料永遠最新:只要更新檔案或網頁,再問同題就能反映新資訊,省下重訓模型的成本。

- 可追溯:AI 引用哪一份文件、一篇新聞,一目了然。

生活化例子

- 你問 ChatGPT:「iPhone 17 什麼時候上市?」如果沒開 RAG,它可能靠記憶猜答案。開了 RAG,它會先去搜尋最新新聞 → 找到發表會日期 → 再回來告訴你「9 月 10 日,來源在這裡」。

- 公司內部 Copilot:你問「我們的假日政策是什麼?」RAG 會去雲端硬碟抓《員工手冊》那一段規定,再整理條列給你。

一句話總結

- RAG = AI 的「即時查資料+翻譯器」模式:先找、再說,答案既有根據又聽得懂。

會啟動 RAG 的產品情境:

- Google AI Overviews — 在預設搜尋結果頁面自動 Query Fan-out 多條子查詢,檢索最新網頁,再用 Gemini 生成帶來源的摘要。

- Google AI Mode — Search 頂部新分頁,透過 Query Fan-out 同時發出數百條搜尋請求,深度檢索並產出可追問的長篇回答,附上原始鏈結。

- Gemini Pro 2.5:google_search tool(Grounding with Google Search)— 即時網頁檢索並回傳 groundingMetadata。

- ChatGPT (o3 系列):Search/Browse with Bing:即時網頁檢索 + 來源腳註;Deep Research:代理式多輪檢索產出長篇報告。

- Amazon Q Business — 預設聊天與外掛 Plugins(Jira、Salesforce…)皆先檢索企業文件再生成回答。

- Anthropic Claude 3:Research 模式:多步網頁查詢+引用。

- Perplexity AI:Answer Engine(一般對話) — 先即時搜尋再生成、附上來源;Deep Research 模式 — 迭代式檢索+文件閱讀。

為什麼需要 RAG?——七個核心理由

1. 減少幻覺、提升可信度

LLM 若只靠訓練參數,容易在缺乏記憶時「編故事」。RAG 先檢索可驗證片段,再讓模型生成,能大幅降低不實陳述的機率;最新系統化回顧將「降低幻覺」列為 RAG 的首要價值。業界觀察也指出,將回答「錨定」(Grounding)在真實文件,是當前最有效的幻覺緩解手段

2. 即時更新知識,不必重訓模型

傳統做法要把新資料「烤」進模型才能生效;RAG 只需把最新內容寫入向量索引,檢索器就能立即取用,知識鮮度與資料庫同步。這讓動態領域(新聞、金融、法規)得以在分鐘級更新。

3. 降低成本,迭代更敏捷

開發成本:Fine-tune 需 GPU 訓練、監督資料與反覆調參;RAG 則多半停留在「嵌入 → 建索引」的離線流程,資源消耗小得多。

4. 突破上下文長度限制

即便是 1M-token 的長上下文模型,也無法裝下整座知識庫。RAG 透過「需要時再撈」的檢索策略,把 relevant 內容壓縮到幾千 token 內,兼顧速度與完整性。

5. 可引用來源、提升可解釋性

RAG pipeline 通常把檢索片段與答案一起返回,方便在 UI 直接顯示「引用 #3 來源」。這對醫療、金融、法律等高監管場景至關重要,可追溯並接受審計。

6. 精準權限控制與隱私合規

向量庫可依檔案權限隔離,檢索階段就能擋掉未授權文件;相比把機密資料烤進模型參數(難以刪除),RAG 更符合資料主權與「被遺忘權」要求。

7. 靈活混搭:與 Fine-tune、Tool-use 並行

RAG 並非萬能,但它能與其他技術互補:先 fine-tune 模型語氣/格式,再用 RAG 注入最新事實。針對計算、資料庫查詢,可在檢索階段串更多工具或 API,擴充能力。

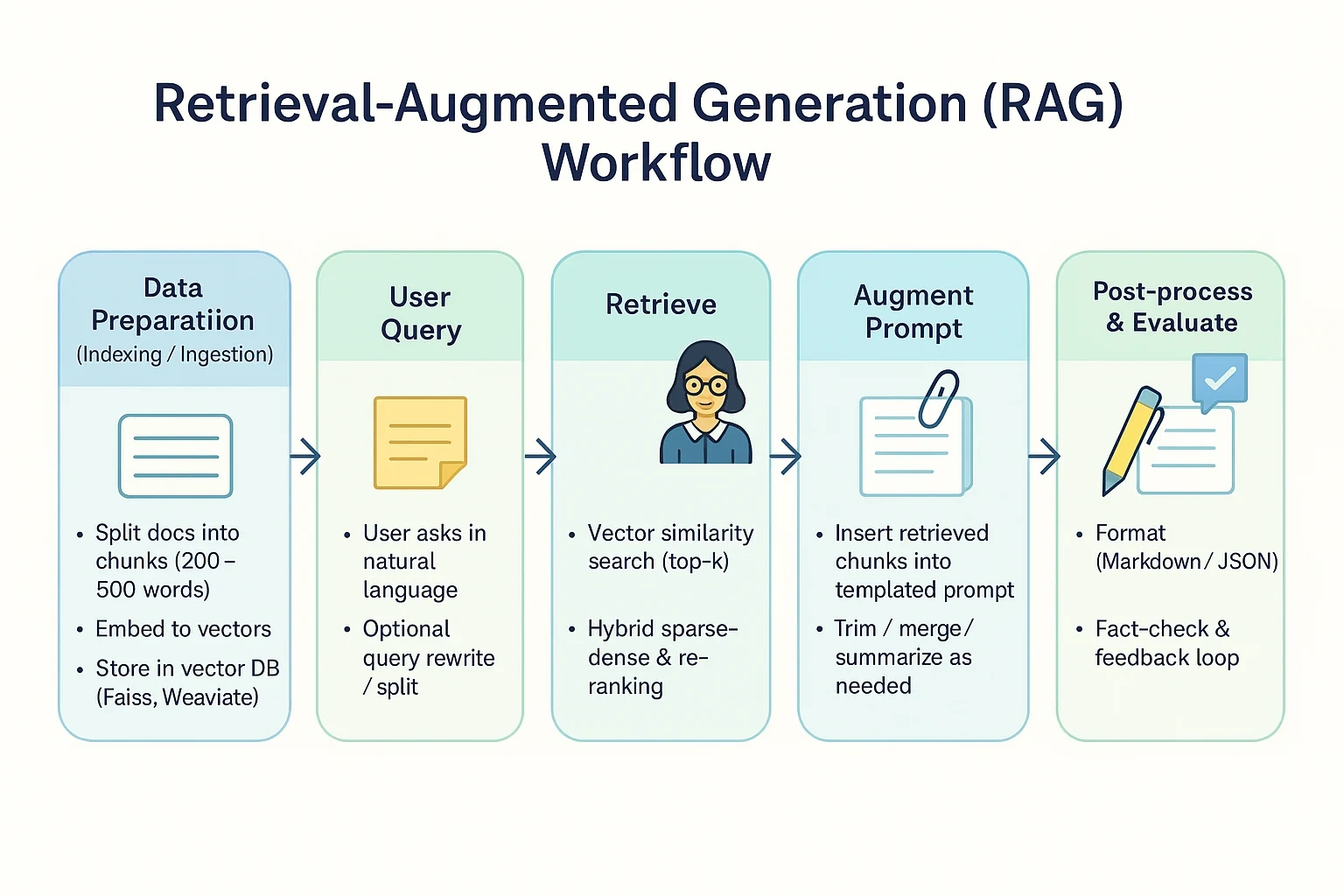

RAG 的運作流程及步驟

以下說明 RAG 的運作及步驟,我已提供了好懂的比喻,幫助你容易理解。

1. 資料準備(Indexing / Ingestion)

- 切分:將文件切成小片段(例如 200–500 字),避免一次塞太多上下文。

- 向量化:用 Embedding 模型把文字轉成數值向量。

- 存庫:把向量丟進向量資料庫(如 Faiss/Weaviate)。

比喻:好比先把整套百科拆成「小卡片」分類,之後要找任何主題都能迅速翻到。

2. 使用者提問(Query)

- 使用者輸入自然語言問題。

- 系統也可以幫忙重寫或拆分問題(query rewrite)以提升檢索覆蓋率。

比喻:就像把疑問寫在便利貼交給圖書館員,請他幫忙找資料。

3. 檢索(Retrieve)

- 讀取問題向量,與資料庫比對相似度,抓出 k 個最相關片段。

- Hybrid/稀疏+稠密檢索:結合關鍵字與語意相似度。

- Re-ranker:再用小模型把候選片段重新排序,提高精度。

比喻:就像館員拿著那張便利貼在書架間穿梭,挑出最符合主題的幾頁書給你。

4. 增強 Prompt(Augment)

- 把檢索到的片段,以 系統化模板(含角色、格式、約束)拼接到 LLM 的提示詞中。

- 控制長度:過長的 context 會稀釋注意力,可用 Chunk(合併/摘要)技巧。

比喻:像把找到的重點頁影印後,用迴紋針夾在問題後面,一併遞給寫稿的專家。

5. 生成(Generate)

- LLM 讀取「問題+增強內容」產生答案。

- 因為答案引用了最新上下文,能顯著降低胡亂編造。

比喻:好比專家看完影印資料後,用自己的話寫出一篇清楚易懂的解答稿。

6. 後處理與評估(Post-processing / Evaluation)

- 格式化:加條列、Markdown、JSON…取決於下游需求。

- 檢查:自動評分(如 RAGAS、GPT-4o 批改)確認引用是否被真正使用、事實是否正確。

- 回饋迴圈:把錯誤樣本加入評測集,持續微調 Retriever 或 Prompt。

比喻:就像主編最後校稿、劃重點,並附上參考書目,確保文章無誤再出刊。

Grounding 與 RAG 的差異?

Grounding 是什麼?

在生成式搜尋(Generative Search)中,grounding(錨定、接地)指的是「把大型語言模型(LLM)的回答錨定到可驗證的資料來源,並附上引用」。

Google Vertex AI 文件明確說明:將模型輸出連結到世界知識或自有文件,可減少幻覺並提高可信度。

Microsoft、AWS 等也把 grounding 視為 Retrieval-Augmented Generation(RAG)工作流中的關鍵步驟,用外部檢索結果餵給 LLM,讓回答更準確且可追溯。

延伸閱讀:《Grounding 介紹:被 Google AI 引用的祕密,就在 Grounding 中》。

看到這裡你應該也會感覺到:感覺 Grounding 跟 RAG 很相似?

接下來我們來進一步理解這兩者的差異。

兩者差異:

- Grounding 指「讓模型的回答與可驗證的外部事實連結在一起」,重點是結果可信。

- RAG(Retrieval-Augmented Generation) 是一種把「檢索系統」接到 LLM 前面的實作架構,常被用來實現 grounding,但兩者不等同。

概念層級差別

- Grounding 是「品質要求」——你希望輸出帶得出來根據,能追溯、能核驗。

- RAG 是「工程做法」——用「先檢索、後生成」的流程,把最新或私有知識餵進模型。

典型流程對照

Grounding 的思考流程

- 先確定哪裡有可靠資料(檢索庫、API、感測器、知識圖譜都行)。

- 生成內容時,引用或嵌入這些資料。

- 回答裡顯示來源(網址、段落、信心分數等)或至少可被驗證。

RAG 的實作步驟

- 解析使用者問題,轉成檢索查詢(關鍵字或向量)。

- 從索引抓出前 k 個相關片段。

- 把這些片段一起塞進 prompt(也就是「Augment」)。

- LLM 讀到擴充後的 prompt,再產生回答。

- 視需求在回答中插入引用或評分。

第 3 步實際上就替模型「鋪好」了 grounding data。

RAG 與 Grounding 關係與常見誤解

用 RAG 不代表一定沒有幻覺;檢索到的片段可能不準確,或 prompt 太長被截斷,仍需額外的「真實性檢查」。

Grounding 不一定得靠 RAG:

- 若資料來源是即時 API(例如股價、天氣),你可以直接把 API 回傳值貼進回答。

- 也可以在生成完畢後,用另一個驗證器模型檢查內容是否被資料支持,再決定是否顯示。

Fine-tune ≠ Grounding:微調把知識寫進模型權重;Grounding / RAG 則是用「外部記憶」補充最新或私有資訊。

小結

- Grounding 關注「答案有沒有憑有據」。

- RAG 關注「怎麼把這些據帶進模型」。

- RAG 常被拿來做 grounding,但 grounding 也可以靠 API、知識圖譜或獨立驗證器來完成。

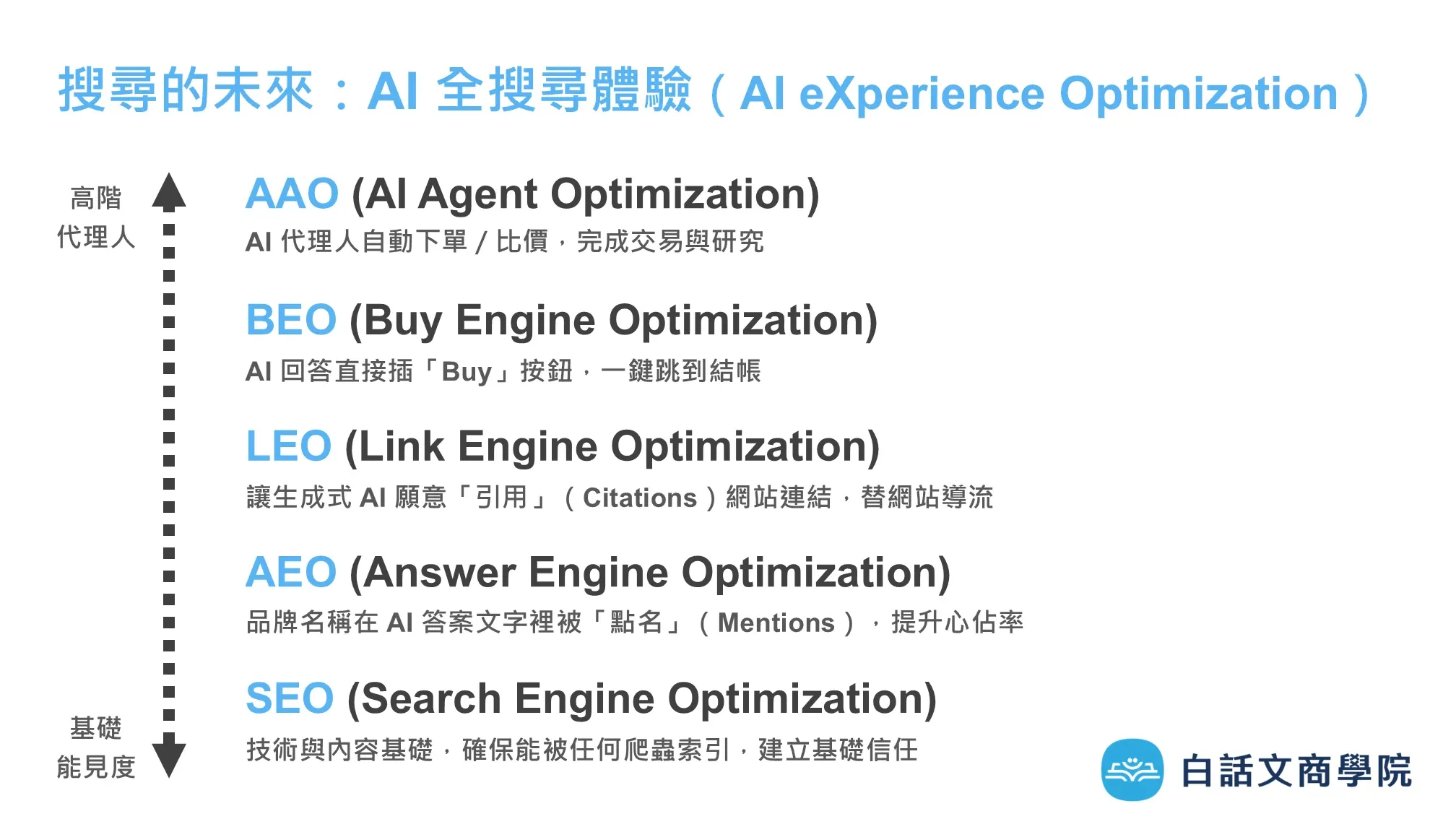

SEO 的新未來:AXO(AI eXperience Optimization)

隨著 AI 搜尋的發展,我們希望出現在各個 AI 搜尋引擎、各個垂直的搜尋引擎。

在 AXO(AI eXperience Optimization)中,我根據不同的層次,分類了 AAO、BEO、GEO、AEO、SEO,定義了不同的工作任務。

SEO 找得到 → AEO 說得到 → GEO 連得到 → BEO 買得到 → AAO AI 替你做到。

延伸閱讀:《AXO(AI 全搜尋體驗)介紹:一次理解搜尋的未來與布局》

RAG 相關問題

RAG 是什麼?

RAG(Retrieval-Augmented Generation)把資訊檢索與大型語言模型黏在一起:先到文件庫抓出與問題相符的片段,再讓模型依據這些片段即時完成回答。RAG 像給 LLM 插上「即插即用的外部記憶」,因此面對從未見過的新政策或內部專用文件,也能說出有根據的答案,同時還能顯示來源方便核對。

RAG 怎麼訓練?

真正需要「訓練」的是檢索管線而非大模型:先把原始文件清洗、切塊、向量化並存入向量資料庫,再用對比學習或強化學習去微調檢索器,讓它更懂得抓重點。生成模型通常只做輕量微調(如 LoRA)或甚至零微調就能上陣,只要整體流程持續評測、回饋、更新索引,就算新文件天天進來也不怕。

RAG 的主要目的?

RAG 的首要任務是把「最新或私有知識」即時灌入回答,避免模型卡在舊資料庫裡。透過附帶引用段落,RAG 同時降低幻覺、提高可追溯性,讓使用者一眼就能驗證真偽。結果是知識覆蓋面更廣、答案更可靠,特別適合法務、金融、技術支援等必須講求正確性的場景。

為什麼要用 RAG?

相較動輒百億參數的全面微調,RAG 只要維護檢索管線,就能用較小的計算量跟成本獲得「新、準、可查」的回應。私有文件停留在檢索階段,不進大模型權重,既符合企業資料治理也方便快速下線或更新。當你需要即時知識又在意隱私與成本,RAG 往往是效率最高、風險最低的選擇。